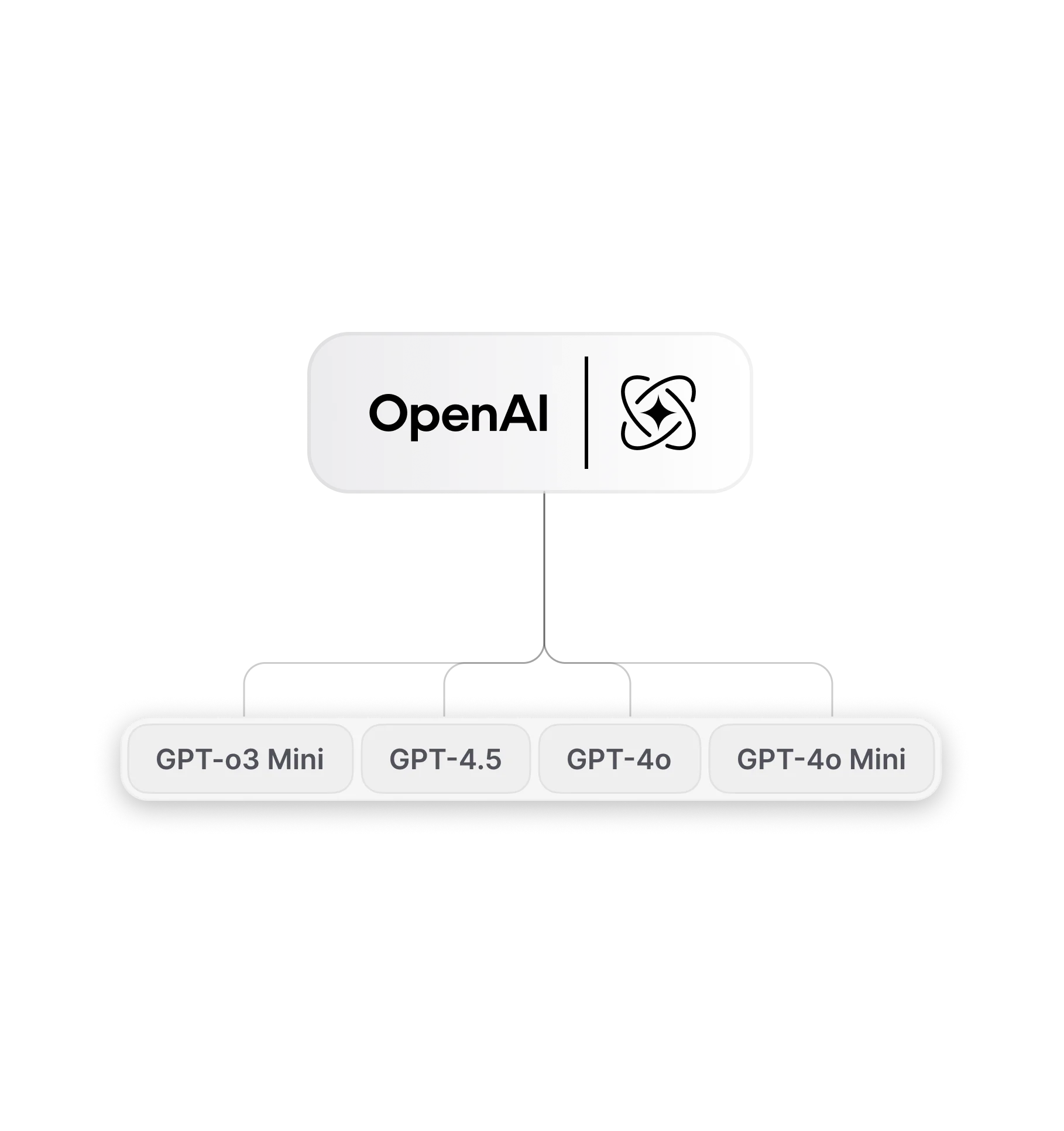

Chat & Ask AI : Développé sur des modèles OpenAI

Chat & Ask AI intègre plusieurs variantes de modèles OpenAI pour prendre en charge des tâches allant du raisonnement analytique au traitement multimodal et aux interactions à réponse rapide. Les modèles couvrent différents niveaux de capacités : raisonnement de haute précision, assistance au codage, interprétation d’images et modes à latence réduite. Chaque instance affiche un comportement prévisible lors du traitement de documents, de code, d’images ou de requêtes conversationnelles, permettant des flux de travail cohérents en recherche, production de contenu et résolution de problèmes.

Modèles avancés d’IA : Basés sur GPT-4o et GPT-5.1

La famille OpenAI dans Chat & Ask AI comprend des systèmes à grande échelle développés sur des infrastructures d’entraînement avancées. La plateforme prend en charge des instances construites sur GPT-4o, alimentées par GPT-4o-mini, construites sur GPT-4.1, développées sur OpenAI o3, alimentées par GPT-5, et alimentées par GPT-5.1. Certaines instances se concentrent sur un raisonnement à étapes et de haute précision ; d’autres combinent entrées image et texte pour des tâches multimodales ; des variantes orientées vitesse privilégient des temps de réponse plus courts. Ces options reflètent un développement par paliers de l’architecture et de l’entraînement et sont proposées comme instances sélectionnables dans l’environnement Chat & Ask AI.

Rôles des modèles et positionnement technique

Différentes versions architecturales occupent des rôles techniques distincts. Les instances analytiques mettent l’accent sur le raisonnement structuré et la gestion de contextes étendus. Les instances multimodales acceptent images et texte et renvoient des réponses intégrées. Les instances axées sur la rapidité sacrifieront la rétention de contexte étendu au profit d’une latence plus faible. Les instances dédiées au code privilégient des complétions sensibles à la syntaxe et une aide contextuelle au débogage. Chaque instance est positionnée pour soutenir des besoins de flux de travail spécifiques sans prétendre à des comparaisons compétitives.

Capacités, gestion des entrées et fonctionnalités principales

Les modèles acceptent des invites en texte clair, des documents structurés, des extraits de code et des entrées d’images. Les modes de contexte long traitent des documents étendus ou des conversations en plusieurs parties en utilisant des fenêtres de contexte plus larges lorsque disponibles. La prise en charge multimodale extrait des éléments visuels, des légendes ou des détails d’objets à partir d’images et les intègre au raisonnement textuel.

Parmi les instances, les capacités communes incluent le raisonnement structuré, l’assistance au codage, la production multilingue et la compréhension multimodale. Les modèles bâtis sur des architectures partagées fournissent génération en langage naturel, synthèse et résumé d’informations à partir d’entrées variées.

Raisonnement, codage et capacités multimodales

Pour le raisonnement, les modèles suivent généralement des approches par étapes : analyser les prémisses, produire des étapes intermédiaires et générer des conclusions. Les requêtes liées au code bénéficient de complétions conscientes de la syntaxe, d’exemples contextuels et d’analyses d’erreurs. Pour l’analyse, les modèles peuvent parser des tableaux, extraire les indicateurs clés et esquisser des étapes procédurales pour des calculs ou des investigations.

Les instances multimodales interprètent les images et relient les caractéristiques visuelles aux descriptions textuelles, permettant des résumés ou annotations basés sur l’image. Les modes de contexte long acceptent des entrées étendues telles que documents de plusieurs pages, transcriptions ou conversations multi‑tours, réduisant la répétition du contexte dans les invites.

Utilisation, flux d’interaction et disponibilité

L’interface Chat & Ask AI expose des contrôles de sélection de modèle, des options de téléversement d’entrées et des préréglages de tâches. Un flux typique consiste à sélectionner une instance modèle, saisir une invite ou téléverser un fichier (PDF, Word, images, code), puis soumettre la requête. Les réponses peuvent comprendre des résumés textuels, des exemples de code, des analyses d’images ou des sorties annotées selon le type d’entrée et le mode du modèle.

La disponibilité des modèles s’aligne sur la capacité de la plateforme et les mises à jour planifiées. En cas de limites d’utilisation ou de fenêtres de maintenance, l’interface indique la disponibilité actuelle et suggère des instances alternatives le cas échéant.

Foire Aux Questions

Quels sont les modèles OpenAI disponibles dans Chat & Ask AI ?

Les instances disponibles comprennent des options construites sur GPT-4o, alimentées par GPT-4o-mini, construites sur GPT-4.1, développées sur OpenAI o3, alimentées par GPT-5, et alimentées par GPT-5.1.

Comment ces modèles gèrent-ils le texte, les images ou d’autres entrées multimodales ?

Les instances acceptent des entrées textuelles et visuelles ; les instances multimodales analysent le contenu visuel et le combinent avec des invites textuelles pour produire des réponses intégrées.

Les modèles OpenAI sur Chat & Ask AI ont-ils des limites d’utilisation ou des contraintes de contexte ?

Oui. Les limites d’utilisation et les contraintes de fenêtre de contexte dépendent de l’instance sélectionnée et des contrôles de débit de la plateforme.

Comment les utilisateurs peuvent-ils accéder ou basculer entre différents modèles OpenAI ?

La sélection de modèle est disponible dans l’interface ; le changement redirige les requêtes vers l’instance choisie et applique ses caractéristiques d’entrée et de sortie.

Les modèles OpenAI conviennent-ils pour des tâches telles que le codage, l’analyse et la génération de contenu ?

Oui. Des instances spécifiques sont conçues pour la complétion de code, le raisonnement analytique et les flux de travail de génération de texte.

Existe‑t‑il un moyen gratuit d’utiliser les modèles OpenAI dans Chat & Ask AI ?

Des options d’accès de base sont proposées ; les détails relatifs à un éventuel niveau gratuit figurent dans les écrans de compte et d’intégration.

Comment fonctionne la tarification des modèles OpenAI lorsqu’ils sont utilisés via la plateforme ?

La tarification et les niveaux d’accès sont gérés par la plateforme et présentés au moment du paiement ou sur les pages de mise à niveau de compte.

Que doivent faire les utilisateurs si un modèle OpenAI semble indisponible ou ne répond pas ?

Vérifier les indicateurs d’état de la plateforme, puis réessayer ou sélectionner une instance alternative après un court délai.

Comment les modèles gèrent-ils la sécurité, la précision et la fiabilité des réponses générées ?

Des contrôles de sécurité et de modération sont appliqués lors du traitement des requêtes ; les sorties peuvent contenir des avertissements et recommander une vérification pour les tâches critiques.

Les modèles OpenAI peuvent‑ils être utilisés pour la création d’images ou d’autres tâches créatives ?

Oui. Les tâches créatives telles que la génération d’images et les rendus stylisés sont prises en charge par des instances acceptant des invites créatives et des instructions d’image.

Comment l’accès aux mises à jour des modèles ou aux nouvelles versions est‑il géré sur la plateforme ?

Les mises à jour des modèles sont déployées via des versions de la plateforme et des notes de mise à jour ; de nouvelles instances apparaissent dans l’interface de sélection de modèle.