Perplexity AI: Inteligencia basada en recuperación y descripción general del sistema

Perplexity AI se presenta como un sistema de generación aumentada por recuperación, construido sobre la noción de perplexity, que combina la recopilación de información en vivo con razonamiento impulsado por modelos para producir respuestas citadas y vinculadas a fuentes. La arquitectura se centra en respuestas respaldadas por evidencias y en apoyo estructurado a la investigación mediante la integración de búsqueda web, indexación e interpretación en múltiples pasadas. Las salidas enfatizan la trazabilidad: las afirmaciones fácticas van acompañadas de enlaces a las fuentes, sellos temporales cuando están disponibles y resúmenes concisos que hacen referencia al material subyacente. El sistema alinea la recuperación de datos externos con el razonamiento del modelo para generar respuestas presentadas con citas explícitas y contexto de fuente accesible.

¿Qué es Perplexity? Diseño central y flujo de recuperación

Perplexity se centra en una canalización de recuperación que recopila documentos externos, clasifica pasajes relevantes y sintetiza esas entradas mediante un modelo generativo. El flujo de trabajo comienza con el análisis de la consulta y avanza a través de etapas de recuperación: búsquedas basadas en índices, búsqueda web en tiempo real y extracción dirigida de páginas de alta relevancia. Los elementos recuperados pasan por capas de agregación que extraen fragmentos, metadatos y marcadores de procedencia. Una pasada de razonamiento interpreta el contenido agregado para formar una respuesta coherente. El ensamblado de citas adjunta enlaces a las fuentes y breves extractos para que las afirmaciones puedan verificarse y seguirse la pista de la investigación. Los componentes principales que influyen en el comportamiento incluyen etapas de recuperación, algoritmos de clasificación, módulos de agregación, pasadas de razonamiento y formato de citación.

Cómo Perplexity procesa las consultas

El procesamiento de consultas sigue pasos discretos desde el análisis inicial hasta la recuperación clasificada y la interpretación del modelo. Una consulta enviada se analiza para determinar la intención y los términos clave, lo que activa búsquedas en índices y consultas en vivo. Los pasajes candidatos se clasifican por relevancia y actualidad, y luego se consolidan en un contexto de trabajo. El modelo lee ese contexto a lo largo de una o más pasadas de razonamiento, produciendo una respuesta resumida mientras preserva los enlaces a los pasajes originales. Una capa de citación formatea las referencias, a menudo incluyendo URL directas, títulos de sitios y textos extractados. El proceso es iterativo: aclaraciones de seguimiento provocan ciclos adicionales de recuperación y razonamiento para refinar la salida.

Funciones orientadas a la investigación y formato de salida

Las salidas están estructuradas para apoyar flujos de trabajo de investigación. Los elementos típicos incluyen un resumen conciso, una lista de fuentes enlazadas con breves extractos y desgloses explicativos opcionales que describen cómo la respuesta se derivó del contenido recuperado. Para consultas extensas, el sistema puede proporcionar resúmenes seccionados, citas textuales y notas de procedencia que indiquen qué fuente respalda cada afirmación. Interpretaciones de seguimiento o pasos sugeridos pueden aparecer como rondas adicionales de recuperación que amplían o acotan el conjunto de evidencias. El formato es modular: respuestas, citas y extractos de fuentes se presentan como elementos discretos pero conectados para una revisión transparente.

Capacidades clave y características técnicas

El sistema combina datos externos e inferencia del modelo para producir síntesis respaldadas por fuentes. Las características técnicas centrales incluyen agregación rápida de contenido web, clasificación en múltiples etapas para priorizar pasajes relevantes y razonamiento del modelo que mapea la evidencia recuperada en respuestas concisas. Las tareas adecuadas para este diseño incluyen consultas con gran carga de datos, investigación exploratoria, explicaciones técnicas y situaciones que requieren un aporte de fuentes explícitas. La plataforma conecta la información recopilada con resúmenes generados por el modelo manteniendo ventanas de contexto por token pobladas con pasajes priorizados y metadatos de procedencia. La estructura de salida típicamente separa el texto sintetizado de las listas de citas e incluye enlaces que permiten la inspección directa de los materiales originales.

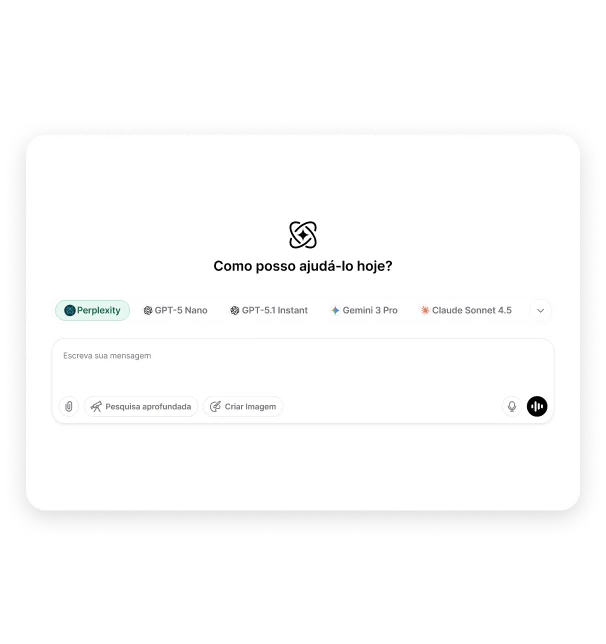

Uso de flujos de trabajo inspirados en Perplexity dentro de Chat y Ask AI

Dentro de Chat y Ask AI, el comportamiento mejorado por recuperación sigue un flujo funcional: seleccionar un modelo apropiado, enviar una consulta o cargar un documento y revisar la salida estructurada que empareja respuestas sintetizadas con enlaces a las fuentes. Para búsquedas factuales, el sistema activa rutinas de búsqueda web y análisis de documentos que suministran al modelo evidencias priorizadas. Para la interpretación de documentos, los archivos cargados se analizan y se extraen pasajes clave antes de alimentarlos a las pasadas de razonamiento. Las solicitudes de información en tiempo real provocan componentes de búsqueda en vivo y citaciones con sellos temporales. El flujo de trabajo es modular, permitiendo ciclos adicionales de recuperación y solicitudes de aclaración para refinar los resultados mientras se preserva la trazabilidad de las fuentes.

Preguntas Frecuentes

¿Qué es Perplexity AI?

Perplexity AI es un sistema de generación aumentada por recuperación, construido sobre la noción de perplexity, que integra búsqueda web, indexación y razonamiento de modelos para producir respuestas citadas.

¿Cómo genera Perplexity respuestas citadas?

El sistema recupera pasajes relevantes, los clasifica, consolida el contexto, ejecuta pasadas de razonamiento y ensambla citas con enlaces y extractos vinculados al material fuente.

¿Cómo funciona la generación aumentada por recuperación?

La generación aumentada por recuperación añade documentos recuperados externamente al contexto de trabajo de un modelo generativo para que las respuestas puedan sintetizarse con citación.

¿Perplexity depende de información en tiempo real?

Las canalizaciones de recuperación pueden incluir búsqueda web en vivo además de contenido indexado, lo que permite respuestas que incorporan información reciente cuando está configurado para hacerlo.

¿Qué tipos de tareas se admiten?

Se admiten tareas como búsquedas factuales, explicaciones técnicas, consultas con gran volumen de datos, resúmenes de literatura, análisis de documentos e investigación exploratoria.

¿Cómo procesa Perplexity consultas largas o complejas?

Las consultas largas o complejas desencadenan recuperación y agregación en múltiples pasadas, dividiendo los resultados en pasajes focalizados que el modelo sintetiza a través de pasos iterativos de razonamiento.

¿Cómo maneja la plataforma la exactitud y las citas?

La exactitud se aborda mostrando enlaces a fuentes, extractos y metadatos de procedencia para que las afirmaciones puedan verificarse; el ensamblado de citas vincula las declaraciones a pasajes recuperados específicos.

¿De qué fuentes se alimenta Perplexity?

Las fuentes suelen incluir páginas web indexadas, sitios de noticias, artículos de investigación, repositorios públicos y otros contenidos en línea accesibles seleccionados por relevancia y actualidad.

¿Perplexity admite entradas multimodales?

El soporte multimodal depende de las canalizaciones configuradas; algunas implementaciones aceptan documentos, enlaces web y, en casos selectos, contenido no textual para procesamiento posterior.